项目介绍

在技术文档、开源项目、博客创作等领域,Markdown 已成为主流的文本标记语言。然而,大多数翻译工具在处理 Markdown 内容时,容易破坏其原有结构,尤其在涉及代码块、LaTeX 公式或结构化元数据时,常常导致格式错乱或语义丢失。

md-translator 致力于解决这一问题:在精准保留 Markdown 格式的同时,实现高质量翻译。其“纯文本翻译模式”更可用于处理任意类型的文本文档,实现格式保留与语言转换的灵活兼容。目前已支持 70 多种语言,并可同时输出多语言结果,助力内容全球化。

特色功能

原生支持 Markdown 元素结构

md-translator 针对 Markdown 文档进行了深度适配,能够识别并还原以下常见语法:

- FrontMatter 元数据(

---) - 标题(

#) - 引用块(

> 引用) - 链接(

[text](URL)) - 无序列表(

-/*/+) - 有序列表(

1. 2. 3.) - 强调文本(

**加粗**,_斜体_) - 代码块(

```) - 内联代码(

`code`) - 行内 LaTeX 公式(

$公式$) - 块级 LaTeX 公式(

$$公式$$)

其中,FrontMatter、代码块以及 LaTeX 公式均支持可选翻译,用户可根据实际需求灵活配置是否处理。

上下文关联翻译 (Context-Aware)

Markdown 文档同样支持上下文关联翻译模式(仅限 AI 模型)。该模式会将文档切分为若干片段,并附带前后文发送给大模型,从而显著提升段落间的连贯性和专业术语的一致性。

由于 Markdown 结构的复杂性,开启上下文模式可能会增加模型输出格式错误的风险(如代码块闭合异常、列表缩进错乱)。建议在开启该模式时,密切关注翻译结果的格式完整性。

支持任意文档的“纯文本翻译模式”

除了结构化 Markdown 支持,md-translator 还提供 “纯文本翻译模式”,跳过格式解析,直接对原始内容进行语言转换。无论是 Markdown、TXT、HTML、日志文件,甚至是未经整理的技术笔记,都可通过该模式获得准确、高效的翻译结果。

你还可以通过自定义 AI 提示词,进一步提升术语一致性、上下文连贯性以及整体翻译风格的统一性,使翻译输出更贴合你的实际写作需求。

自动适配 RTL 语言

自动识别并调整阿拉伯语、希伯来语、乌尔都语、波斯语等 RTL 语言的显示方向。

扩展功能:提取纯净文本

md-translator 还具备将 Markdown 内容转换为纯文本的能力,方便你进行二次处理或语义分析:

- 自动去除所有 Markdown 标记符号

- 隐藏代码块、链接等技术内容

- 输出适合摘要提取、搜索索引或 NLP 处理的纯文本数据

该功能非常适用于技术内容的摘要提取、语义分析、知识图谱构建等自动化应用场景。

适用场景

- 多语言技术文档的批量翻译

- 开源项目说明文档的国际化

- Markdown 博客内容的中英双语同步

- 代码注释、公式说明等混合文档的格式保留翻译

- 任何结构化/非结构化文本的语义翻译与提取

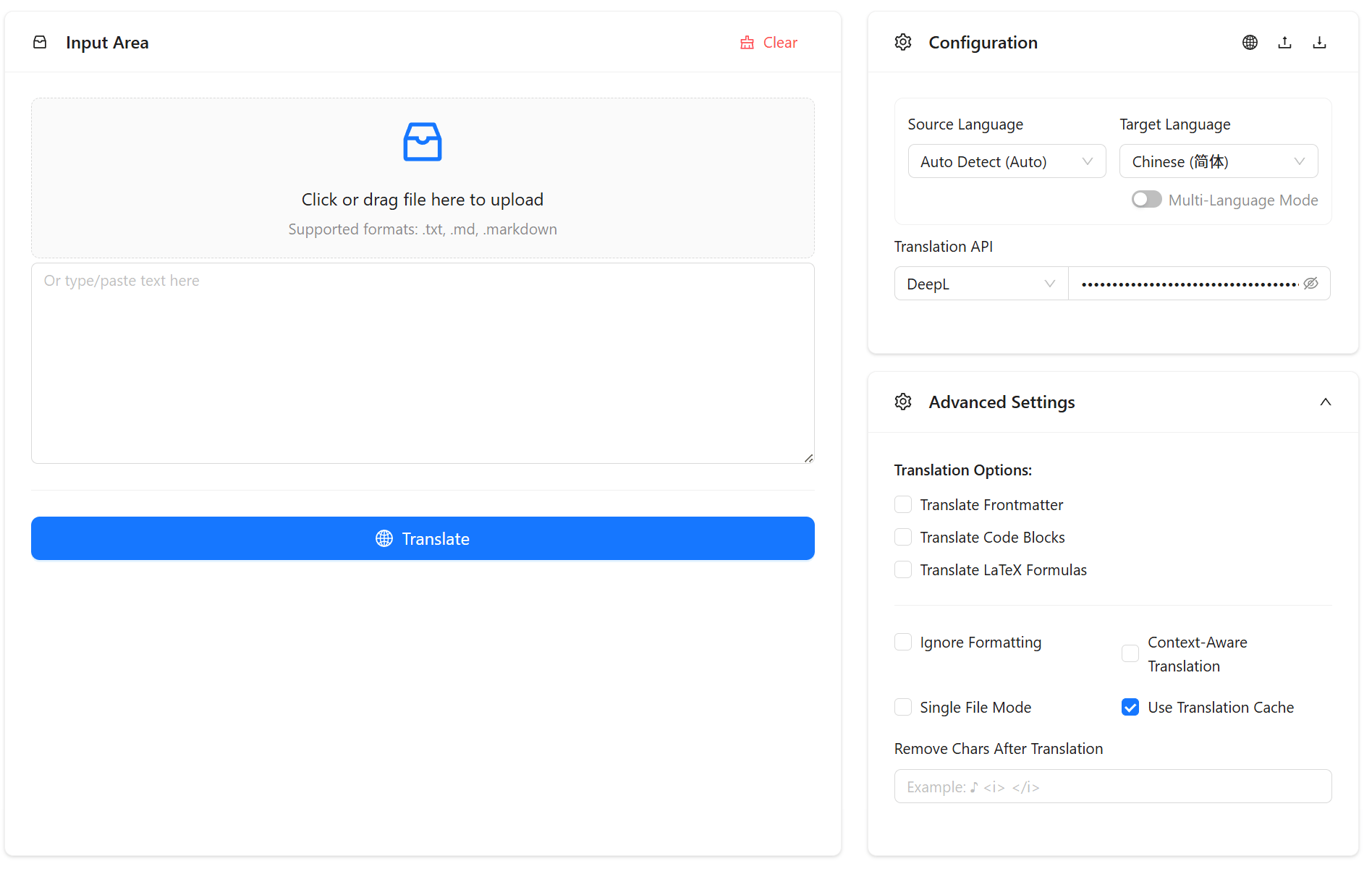

配置说明

应用提供了丰富的翻译配置选项,详细信息请参考: